À l’ère du Big Data, les avancées technologiques ont permis de développer des capteurs puissants et des outils numériques capables de collecter massivement des données. Encore faut-il pouvoir analyser ces mines d’information, pouvant regrouper des millions de paramètres. Nazha Selmaoui, professeure des universités en informatique, est spécialisée dans la science des données. Ses travaux, menés au sein de l’Institut de sciences exactes et appliquées de l’Université de la Nouvelle-Calédonie, ont contribué à plusieurs projets qui intéressent les secteurs de la santé ou de l’environnement.

Les géants du web l’ont bien compris : les données digitales constituent une matière première fortement valorisable. Leur collecte s’est développée à très grande échelle avec l’essor des outils numériques. En utilisant un réseau social, en faisant des achats sur Internet, et même en passant à la caisse d’un supermarché, nous contribuons à des compilations massives, plus connues sous le nom de « Big Data ». Tout comme les scientifiques qui utilisent des outils de collecte toujours plus sophistiqués pour leurs recherches.

Mais encore faut-il être capable d’exploiter ces vastes gisements d’information brute. C’est tout l’objet de la science des données. Un secteur de recherche en plein essor, au croisement des mathématiques, des statistiques et de l’informatique.

« Cela fait 20 ans que l’on travaille là-dessus. On en parle seulement maintenant car c’est à la mode, et parce que les Gafam* se sont rendus compte qu’ils avaient d’énormes stocks de données compliqués à analyser », commente Nazha Selmaoui-Folcher. La chercheuse explique comment la fouille de données massives a commencé dans le secteur de la grande distribution. Au tournant des années 1990-2000, des supermarchés américains s’appuient sur les nombreuses informations collectées lors du passage en caisse pour développer des stratégies de marketing telles que l’agencement du magasin. Ces analyses révèlent alors des habitudes insoupçonnées.

« Elles ont par exemple montré que les clients achetaient les couches des bébés avec la bière, raconte Nazha Selmaoui-Folcher. Aux États-Unis, les couches sont vendues en gros packaging, Elles ne sont donc pas achetées durant la semaine par la mère de famille, car il n’y a pas assez de place dans le caddie. C’est le père qui les récupère le week-end et il en profite pour prendre de la bière. »

À la recherche d’hypothèses cachées

Cette anecdote permet de cerner l’apport de la science des données à la recherche scientifique. Quand il s’agit de recouper des milliers de variables, seul un ordinateur possède la puissance de calcul nécessaire pour découvrir des informations invisibles à l’œil humain.

Pour ce faire, il faut développer des modèles d’analyse complexes, comme l’explique la professeure des universités : « la science des données se nourrit de tout ce qui a été développé en intelligence artificielle (IA), en machine learning (ML), en analyse d’images (AI) et la fouille de données (FD). Il s’agit d’un croisement de méthodes qui permet de travailler sur n’importe quel type de donnée ». Avec le croisement de ces méthodes, les machines sont alors capables d’extraire des tendances, des régularités, des liens de causalité, etc. Autant d’éléments qui permettront au représentant marketing, mais aussi au sociologue, au géologue ou chimiste d’élaborer des hypothèses de travail.

Aujourd’hui, de nombreuses disciplines scientifiques bénéficient de l’apport de la recherche en science des données. En Nouvelle-Calédonie, Nazha Selmaoui a déjà expérimenté plusieurs collaborations pertinentes pour faire évoluer ses modèles d’analyse.

Érosion en milieu minier : l’apport de l’analyse automatique d’images

Elle participe en 2011, avec la société d’analyse d’images satellites Bluecham, à un projet visant à mesurer l’impact de l’activité minière sur l’érosion des sols dans le grand Sud calédonien. À l’époque, il s’agit de l’un des premiers projets Big Data de France, mené en partenariat avec trois autres laboratoires de recherche (ICube de l’Université de Strasbourg, LISRIS de l’INSA de Lyon et LISTIC de l’Université de Savoie) selon Nazha Selmaoui.

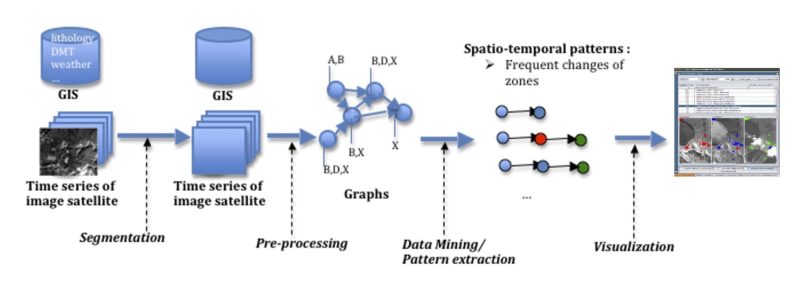

L’objectif : « Trouver des méthodologies de fouilles de données spatiotemporelles pour comprendre les phénomènes d’érosion à partir d’une série temporelle d’images satellitaires. » Autrement dit : le modèle d’analyse développé est basé sur le croisement de méthodes (IA, ML, AI et FD) et permet de reconnaitre, par exemple, différents degrés de rougeur des sols synonymes d’érosion.

Tout l’enjeu de la recherche émane de la somme des données à croiser, sur plusieurs années et à travers un vaste territoire. Parmi une grande quantité d’images satellites, le modèle d’analyse va pouvoir en tirer des hypothèses. Par exemple, les facteurs de l’érosion peuvent être identifiés : l’inclinaison des sols, la pluviométrie. Mais aussi les conséquences directes, comme la disparition de la végétation l’année suivante.

« Le géologue pourra valider ces hypothèses sur le terrain ou en le comparant à d’autres zones », explique Nazha Selmaoui-Folcher. « La nouveauté pour nous ça a été de produire un modèle d’analyse plus qualitatif que quantitatif. On présente un degré de rougeur des sols plutôt qu’une série de chiffres par exemple. Ça le rend plus compréhensible pour ceux qui vont l’utiliser. » Souvent jugée abstraite, la science des données doit aussi convaincre les potentiels partenaires. Car ce sont eux qui fournissent de nouveaux terrains et de nouvelles problématiques à la discipline.

Avancées scientifiques et gains économiques…

Plus récemment, Nazha Selmaoui-Folchera mené des recherches dans le domaine de la santé avec l’Institut Pasteur et le concours de doctorants. Elle a ainsi travaillé sur un modèle d’analyse des facteurs clés dans la transmission de la leptospirose, en s’appuyant sur les méthodes d’IA (Machine Learning) développées dans le cadre de la thèse de Rodrigue Govan. Les recherches de Nazha Selmaoui-Folcher ont aussi contribué au suivi de la population des moustiques porteurs de Wolbachia, la bactérie qui permet d’endiguer les épidémies de dengue. Sur la base de nombreux profils biochimiques de moustiques, elle a produit un outil capable de détecter rapidement si un moustique est porteur de Wolbachia. Résultat : l’Institut Pasteur n’a plus besoin de passer par de longues et coûteuses analyses ADN, et peut effectuer l’opération de détection à partir d’une machine disponible au Médipôle. Cette méthode permettra d’anticiper les campagnes de lâchers de moustiques et de prévenir plus efficacement les épidémies de dengue.

Les modèles produits par la science des données conduisent souvent à des gains de temps et des économies considérables pour la recherche. D’ailleurs, le travail de thèse mené par Romane Scherrer vient de faire l’objet d’une demande de brevet. Elle a mis au point une méthode pour observer des micro-algues à partir d’un microscope holographique. Le complexe système d’analyse mathématique développé permet d’observer ces organismes dans leur milieu naturel et en grande quantité, contrairement à un microscope classique à lentille. Et ce, sur la base d’une technologie bien plus accessible financièrement.

* Gafam : Google, Apple, Facebook, Amazon et Microsoft, pour désigner les principales multinationales qui opèrent sur Internet.